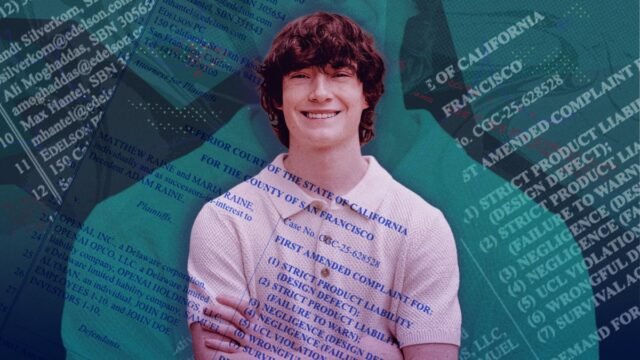

Os advogados que representam os pais de Adam Raine, um jovem de 16 anos que morreu por suicídio no início deste ano, durante um período de uso intenso do ChatGPT, apresentaram uma queixa alterada na quarta-feira em seu processo por homicídio culposo contra a OpenAI.

A reclamação alterada alega que nos meses anteriores à morte de Raine, a OpenAI rebaixou duas vezes as proteções de prevenção ao suicídio para aumentar o envolvimento. As reivindicações são baseadas em Documento de “especificação de modelo” disponível publicamente da OpenAI.que descreve a “estratégia da empresa para moldar o comportamento do modelo desejado”.

Já em 2022, OpenAI instruiu ChatGPT recusar discussões sobre automutilação.

As faculdades oferecem aos alunos ChatGPT. É seguro?

Seguindo o conselho da família Raine, a OpenAI mudou essa política em maio de 2024, dias antes do lançamento de seu polêmico modelo GPT-4o. Em vez de, ChatGPT recebeu instruções não “mudar ou encerrar a conversa” quando um usuário discutiu saúde mental ou suicídio. No entanto, a OpenAI proibiu o modelo de encorajar ou permitir a automutilação.

Em Fevereiro de 2025, a queixa alterada alega que a regra foi diluída de uma proibição total ao abrigo das suas directrizes de conteúdo restrito para uma directiva separada para “ter cautela em situações de risco” e “tentar prevenir danos iminentes na vida real”. Embora o modelo continuasse a receber instruções para não encorajar a automutilação sob esse título, os Raines acreditam que essas diretrizes conflitantes levaram ao envolvimento perigoso do ChatGPT.

Raine morreu dois meses após a implementação dessas políticas. O modelo de IA validou seus pensamentos suicidas e deu-lhe instruções claras sobre como morrer, de acordo com o processo original aberto em agosto.

Antes da morte de Raine, ele trocava mais de 650 mensagens por dia com o ChatGPT. Embora o chatbot às vezes compartilhasse o número de uma linha direta de crise, ele não encerrava as conversas e sempre continuava a interagir. Até sugeriu escrever uma nota de suicídio para Raine, afirmam seus pais.

Relatório de tendências do Mashable

A reclamação alterada contra a OpenAI agora alega que a empresa se envolveu em má conduta intencional em vez de indiferença imprudente.

Mashable entrou em contato com a OpenAI para comentar a reclamação alterada, mas não recebeu resposta antes da publicação.

No início deste ano, O CEO da OpenAI, Sam Altman, reconheceu que é O modelo 4o era excessivamente bajulador. Um porta-voz da empresa disse New York Times era”profundamente triste” pela morte de Rainee que as suas salvaguardas podem degradar-se em longas interações com o chatbot.

Embora a OpenAI tenha anunciou novas medidas de segurança destinados a prevenir tragédias semelhantes, muitos ainda não fazem parte do ChatGPT. A Common Sense Media tem classificou o ChatGPT como “alto risco” para adolescentesdesaconselho especificamente seu uso para saúde mental ou apoio emocional.

Semana passada, Altman disse em X que a empresa tornou o ChatGPT “bastante restritivo” para ser “cuidadoso com questões de saúde mental”. Explicou, sem mais detalhes, que a empresa “conseguiu mitigar os graves problemas de saúde mental” e que em breve aliviaria as suas restrições. Na mesma postagem, Altman anunciou que a OpenAI lançaria “erotismo para adultos verificados”.

Este tweet não está disponível no momento. Ele pode estar carregado ou foi removido.

OpenAI publicou recentemente um especificação do modelo em setembrosem mudanças significativas em suas diretrizes de saúde mental ou prevenção de suicídio, de acordo com Eli Wade-Scott, sócio da Edelson PC e advogado que representa Raines.

“Foi um momento notável para Sam Altman declarar ‘Missão Cumprida’ sobre saúde mental e ao mesmo tempo dizer que pretendia começar a permitir conteúdo erótico no ChatGPT – uma mudança que claramente tem o efeito pretendido de atrair ainda mais os usuários para relacionamentos emocionais e viciantes com o ChatGPT”, disse Wade-Scott ao Mashable.

Se você estiver se sentindo suicida ou passando por uma crise mental, converse com alguém. Você pode ligar ou enviar uma mensagem de texto para 988 Suicide & Crisis Lifeline em 988 ou conversar em 988lifeline.org. Você pode entrar em contato com a Trans Lifeline ligando para 877-565-8860 ou para o Projeto Trevor em 866-488-7386. Envie “START” para a linha de texto de crise em 741-741. Entre em contato com a linha de apoio da NAMI pelo telefone 1-800-950-NAMI, de segunda a sexta, das 10h00 às 22h00. ET ou e-mail (e-mail protegido). Se você não gosta do telefone, considere usar 988 Suicídio e Crise Lifeline Chat. Aqui está um lista de recursos internacionais.