- O Raspberry Pi AI HAT+ 2 permite que o Raspberry Pi 5 execute o LLM localmente.

- O acelerador Hailo-10H oferece 40 TOPS de desempenho de inferência INT4.

- A interface PCIe permite comunicação de alta largura de banda entre a placa e o Raspberry Pi 5.

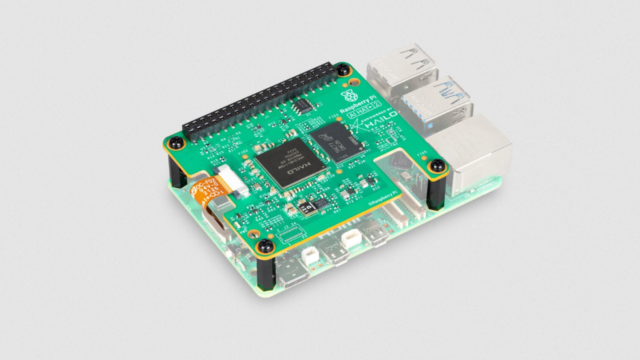

Raspberry Pi expande suas ambições de computação de ponta com seu próximo lançamento. Segura um chapéu+ 2Placa complementar projetada para trazer cargas de trabalho generativas de IA para o Raspberry Pi 5.

O hardware AI HAT anterior concentrava-se quase inteiramente na aceleração da visão computacional, lidando com tarefas como detecção de objetos e segmentação de cena.

O novo conselho expande seu alcance apoiando: Modelos de linguagem em larga escala e modelos de linguagem de visão executados localmente, sem depender de infraestrutura em nuvem ou de acesso persistente à rede.

Mudanças de hardware que permitem modelos de idioma local

No centro da atualização está o acelerador de rede neural Hailo-10H, que oferece 40 TOPS de desempenho de inferência INT4.

Ao contrário de seu antecessor, o AI HAT+ 2 possui 8 GB de memória interna dedicada, permitindo executar modelos maiores sem usar RAM do sistema no host Raspberry Pi.

Essa mudança permite que o LLM e o VLM sejam executados diretamente no dispositivo, mantendo baixa latência e dados locais, que são requisitos essenciais para muitas implantações de borda.

O AI HAT+ 2 se conecta ao Raspberry Pi 5 por meio de um cabeçalho GPIO e usa a interface PCIe do sistema para transferência de dados, o que exclui compatibilidade com o Raspberry Pi 4.

Essa conexão suporta transferência de dados de alta largura de banda entre o acelerador e o host, o que é essencial para mover com eficiência dados de entrada, saída e câmera do modelo.

As demonstrações incluem respostas a perguntas baseadas em texto usando Qwen2, geração de código usando Qwen2.5-Coder, tarefas básicas de tradução e descrições visuais de cenas a partir de imagens de câmeras ao vivo.

Essas cargas de trabalho dependem de ferramentas de IA empacotadas para operar na pilha de software Pi, incluindo back-ends em contêineres e servidores de inferência locais.

Todo o processamento ocorre no dispositivo sem quaisquer recursos de computação externos.

Os modelos suportados variam de 1 bilhão a 1,5 bilhão de parâmetros, o que é modesto em comparação com sistemas baseados em nuvem que operam em escalas muito maiores.

Esses pequenos LLMs visam memória limitada e envelopes de energia, em vez de amplo conhecimento de uso geral.

Para resolver essas limitações, o AI HAT+ 2 oferece suporte a métodos de ajuste fino, como a adaptação de classificação baixa, que permite aos desenvolvedores personalizar o modelo para se adequar a tarefas restritas, deixando a maioria dos parâmetros inalterados.

Os modelos de visão também podem ser treinados novamente usando conjuntos de dados específicos de aplicativos por meio do conjunto de ferramentas da Hailo.

O AI HAT + 2 está disponível por US$ 130 e oferece desempenho de visão computacional semelhante, ao mesmo tempo que supera os acessórios anteriores com foco na visão.

Para cargas de trabalho que se concentram exclusivamente no processamento de imagens, a atualização oferece benefícios limitados, pois os benefícios da atualização são principalmente para execução local de LLM e aplicativos sensíveis à privacidade.

Em termos práticos, o hardware demonstra que a IA generativa no hardware Raspberry Pi agora é possível, embora o espaço de memória limitado e os modelos pequenos continuem sendo desafios.

Siga o TechRadar no Google Notícias e Adicione-nos como fonte preferencial Receba notícias, análises e opiniões de especialistas em seu feed. Certifique-se de clicar no botão seguir!

Claro que você também pode Siga o TechRadar no TikTok Confira novidades, análises, unboxings em formato de vídeo e receba atualizações regulares. WhatsApp fazer.