euontem à noite eu estava navegando em um aplicativo de namoro. Um cara se destacou: “Henrique VIII, 34, Rei da Inglaterra, não monogâmico”. A próxima coisa que sei é que estou num bar à luz de velas, compartilhando um martini com o maior namorador em série do século XVI.

Mas a noite não acabou. Em seguida, sou DJ lado a lado com Diana, Princesa de Gales. “A multidão está pronta para o lançamento”, ela grita em meu ouvido, segurando um fone de ouvido em sua tiara. Karl Marx finalmente explica por que ele não consegue resistir a 60% de desconto, enquanto esperamos no frio para obter os primeiros direitos sobre as vendas da Black Friday.

No Sora 2, se você consegue pensar, provavelmente consegue ver – mesmo quando sabe que não deveria. Lançado em outubro nos EUA e no Canadá apenas por convite, o aplicativo de vídeo da OpenAI atingiu 1 milhão de downloads em apenas cinco dias, superando a estreia do ChatGPT.

Sora não é a única ferramenta de IA generativa de texto para vídeo que existe, mas se tornou popular por dois motivos principais. Primeiro, é a maneira mais fácil para os usuários jogarem seus próprios deepfakes. Escreva um prompt e um vídeo de 10 segundos aparecerá em minutos. Ele pode então ser compartilhado no feed estilo TikTok do próprio Sora ou exportado para outro lugar. Ao contrário do “resíduo de IA” produzido em massa e de baixa qualidade que obstrui a Internet, esses clipes têm valores de produção perturbadoramente altos.

A segunda razão é que Sora permite imagens de celebridades, atletas e políticos – com uma ressalva crucial: eles devem estar mortos. As pessoas vivas devem consentir com as aparências, mas há uma exceção para “figuras históricas”, que Sora parece definir como qualquer pessoa famosa e que já não está viva.

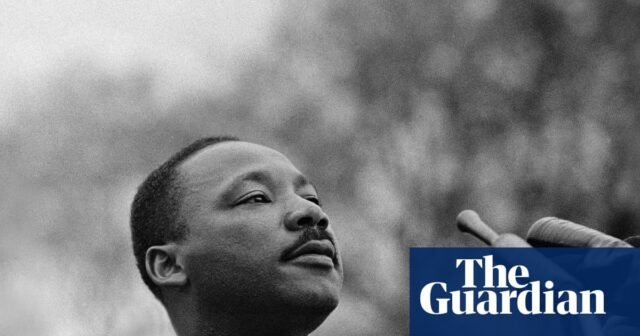

Parece ser isso que a maioria dos usuários tem feito desde o lançamento. A corrente principal é um vórtice surreal de podridão cerebral e líderes históricos. Adolf Hitler passa os dedos por um homem brilhante em um comercial de xampu. A Rainha Elizabeth II se catapulta de uma mesa de bar enquanto pronuncia palavrões. Abraham Lincoln explode de alegria na televisão ao ouvir: “Você não é o pai”. O reverendo Martin Luther King Jr. conta a um funcionário de um posto de gasolina sobre seu sonho de que um dia todos os refrigerantes serão de graça – então pega a bebida gelada e pesa antes de terminar a frase.

Mas os parentes dos retratados não riem.

“É profundamente desrespeitoso e doloroso ver a imagem do meu pai usada de forma tão arrogante e insensível quando ele dedicou sua vida à verdade”, disse Ilyasah Shabazz, filha de Malcolm X. contado Washington Post. Ela tinha dois anos quando seu pai foi assassinado. Hoje, os clipes de Sora retratam o ativista dos direitos civis lutando com MLK, falando sobre defecar em si mesmo e fazer piadas grosseiras. Na sexta-feira, a OpenAI anunciou que “trabalhou em conjunto” com o espólio de Martin Luther King Jr. e, a pedido deles, a OpenAI fez uma pausa de gerações retratando King como a empresa “fortalecendo as salvaguardas para figuras históricas”.

A empresa não fez declarações públicas semelhantes após reclamações de outros familiares de pessoas retratadas no aplicativo. Zelda Williams, filha do ator Robin Williams, implorou às pessoas que “por favor, parem” de enviar vídeos de IA de seu pai, em um post no Instagram. “É estúpido, é uma perda de tempo e energia e, acredite, NÃO é isso que ele iria querer”, disse ela. Pouco antes de sua morte em 2014, o falecido ator tomou medidas legais para impedir qualquer pessoa de usar sua imagem em publicidade ou inseri-lo digitalmente em filmes até 2039. “Ver o legado de pessoas reais condensado em… horrível, o lixo do TikTok tocando em fantoches é uma loucura”, acrescentou sua filha.

Vídeos que lembram o falecido comediante George Carlin são “opressores e deprimentes”, disse sua filha, Kelly Carlin, em um post do BlueSky.

Pessoas que morreram recentemente também foram descobertas. O aplicativo está cheio de vídeos de Stephen Hawking recebendo um “#powerslap” que derruba sua cadeira de rodas. Kobe Bryant bate em uma velha enquanto grita sobre objetos em seu reto. Amy Winehouse pode ser encontrada tropeçando pelas ruas de Manhattan ou chorando para a câmera enquanto o rímel escorre pelo seu rosto.

As mortes dos últimos dois anos – Ozzy Osbourne, Matthew Perry, Liam Payne – estão ausentes, indicando uma fronteira que fica em algum lugar no meio.

Sempre que morrem, esta “brincadeira de marionetas” dos mortos corre o risco de redesenhar as linhas da história, diz Henry Ajder, especialista em IA generativa. “As pessoas temem que um mundo saturado com esse tipo de conteúdo leve a uma distorção dessas pessoas e da forma como são lembradas”, afirma.

O algoritmo de Sora recompensa o valor do choque. Um vídeo no alto do meu feed mostra King fazendo barulhos de macaco durante seu discurso I Have a Dream. Outros retratam Bryant reencenando o acidente de helicóptero que matou ele e sua filha.

Embora atores ou desenhos animados também possam retratar pessoas postumamente, existem salvaguardas legais mais fortes. Um estúdio cinematográfico é responsável pelo seu conteúdo; A OpenAI não é necessariamente responsável pelo que aparece no Sora. Retratar alguém para uso comercial também requer o consentimento do espólio do falecido em alguns estados.

“Não poderíamos simplesmente ressuscitar Christopher Lee intimamente para estrelar um novo filme de terror, então por que a OpenAI pode ressuscitá-lo para estrelar milhares de curtas-metragens?” pergunta James Grimmelmann, especialista em direito da Internet da Cornell Law School e da Cornell Tech.

A decisão da OpenAI de divulgar as personas dos falecidos ao público levanta questões incômodas sobre como os mortos viverão na era da IA generativa.

A questão jurídica

Entregar fantasmas de celebridades para assombrar Sora para sempre pode parecer errado, mas é legal? Depende de para quem você pergunta.

Uma questão importante permanece por resolver na legislação da Internet: as empresas de IA são abrangidas pela Secção 230 e, portanto, não são responsáveis pelo conteúdo de terceiros nas suas plataformas? Se o OpenAI estiver protegido pela Seção 230, ele não poderá ser processado pelo que os usuários fazem no Sora.

“Mas se não houver legislação federal sobre o assunto, haverá incerteza jurídica até que a Suprema Corte avalie o caso – e isso levará mais dois a quatro anos”, disse Ashkhen Kazaryan, especialista em Primeira Emenda e política tecnológica.

Enquanto isso, a OpenAI deve evitar ações judiciais. Isto significa que os vivos devem dar o seu consentimento. As leis de difamação dos EUA protegem pessoas vivas de qualquer “comunicação física que seja prejudicial à reputação de uma pessoa”. Além disso, a maioria dos estados tem leis de direito de publicidade que impedem que a voz, pessoa ou imagem de alguém seja usada sem consentimento para fins “comerciais” ou “enganosos”.

Permitir os mortos “é a maneira de mergulhar o dedo do pé na água”, diz Kazaryan.

Os falecidos não estão protegidos contra difamação, mas três estados – Nova Iorque, Califórnia e Tennessee – concedem um direito post-mortem de publicidade (o direito comercial à sua imagem). Navegar por essas leis no contexto da IA continua sendo uma “área cinzenta” sem precedentes legais, diz Grimmelmann.

Para processar com sucesso, o espólio deve mostrar que a OpenAI é responsável – por exemplo, argumentando que incentiva os usuários a retratar os mortos.

Grimmelmann observa que o site de Sora está cheio desses vídeos, que na verdade promovem esse conteúdo. E se Sora foi treinado em grandes volumes de imagens de figuras históricas, o demandante pode argumentar que o aplicativo foi projetado para recriá-lo.

No entanto, a OpenAI poderia se defender alegando que Sora é puramente para entretenimento. Cada vídeo possui uma marca d’água que evita que seja enganado ou classificado como comercial.

Bo Bergstedt, pesquisador de IA generativa, diz que a maioria dos usuários está explorando, não ganhando dinheiro.

“As pessoas tratam isso como entretenimento, veem que coisas malucas conseguem inventar ou quantas curtidas conseguem”, diz ele. Embora isto possa ser perturbador para as famílias, ainda pode estar em conformidade com as leis de publicidade.

No entanto, se um usuário do Sora construir uma audiência gerando clipes populares de figuras históricas e começar a monetizar o seguinte, ele poderá enfrentar problemas legais. Alexios Mantzarlis, diretor da Iniciativa de Segurança, Confiança e Proteção da Cornell Tech, observa que “desperdício de IA financeira” inclui ganhar dinheiro indiretamente por meio de plataformas monetizadas. As emergentes “influências de IA” de Sora podem, portanto, enfrentar ações judiciais dos mortos se lucrar com os mortos.

Uma estratégia “Whac-A-Mole”

Em resposta à reação, a OpenAI anunciou na semana passada que começaria a permitir que representantes de figuras públicas “falecidas recentemente” solicitassem que suas imagens fossem bloqueadas nos vídeos de Sora.

“Embora existam fortes interesses de liberdade de expressão na representação de figuras históricas, acreditamos que as figuras públicas e as suas famílias devem, em última análise, controlar a forma como a sua imagem é usada”, disse um porta-voz da OpenAI.

A empresa ainda não definiu “recentes” ou explicou como as solicitações serão tratadas. A OpenAI não respondeu imediatamente ao pedido de comentários do Guardian.

Ela também voltou atrás em sua estratégia de direitos autorais livres para todos, depois que conteúdo subversivo como “Bob Esponja nazista” se espalhou pela plataforma e a Motion Picture Association acusou a OpenAI de violação. Uma semana após o lançamento, mudou para um modelo opcional para detentores de direitos.

Grimmelmann espera um pivô semelhante em relação às representações dos mortos. “Insistir que as pessoas tenham que optar por não participar se não gostarem disso pode não ser sustentável”, diz ele. “É estranho, e se eu tenho esse instinto, os outros também terão – incluindo os árbitros.”

Bergstedt chama isso de abordagem “Whac-A-Mole” para as grades de proteção, que provavelmente continuará até que os tribunais federais definam a responsabilidade da IA.

Na opinião de Ajder, a disputa de Sora prenuncia uma questão mais ampla que cada um de nós acabará por enfrentar: quem controla a nossa semelhança na era sintética?

“É uma situação preocupante se as pessoas simplesmente aceitarem que serão usadas e abusadas em conteúdo hiper-realista gerado por IA”.