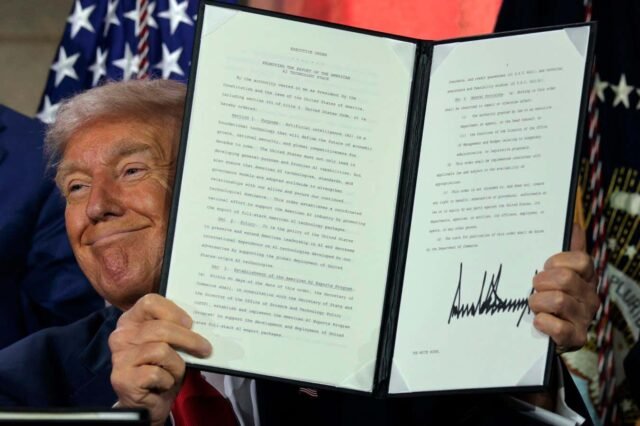

O presidente dos EUA, Donald Trump, exibe a ordem executiva que assinou na Cúpula da IA em 23 de julho de 2025 em Washington, DC

Chip Somodevilla/Getty Images

O Presidente Donald Trump quer garantir que o governo dos EUA apenas conceda contratos federais a criadores de inteligência artificial cujos sistemas estejam “livres de preconceitos ideológicos”. Mas estes novos requisitos poderão permitir à administração impor a sua própria visão do mundo aos modelos de IA das empresas tecnológicas – e as empresas poderão enfrentar desafios e riscos significativos ao tentarem modificar os seus modelos para os cumprir.

“A sugestão de que os contratos governamentais devem ser estruturados para garantir que os sistemas de IA sejam ‘objetivos’ e ‘livres de preconceitos ideológicos de cima para baixo’ levanta a questão: objetivo de acordo com quem?” dizer Becca Branum no Center for Democracy & Technology, uma organização de políticas públicas sem fins lucrativos em Washington DC.

Casa Branca de Trump Plano de Ação de IAlançado em 23 de julho, recomenda a atualização das diretrizes federais “para garantir que o governo contrate apenas grandes desenvolvedores de modelos de linguagem de fronteira (LLM) que garantam que seus sistemas sejam objetivos e livres de preconceitos ideológicos de cima para baixo”. Trump assinou um acordo relacionado ordem executiva intitulado “Preventing Woke AI in the Federal Government” no mesmo dia.

O plano de ação de IA também recomenda que o Instituto Nacional de Padrões e Tecnologia dos EUA revise sua estrutura de gestão de risco de IA para “remover referências à desinformação, Diversidade, Equidade e Inclusão e mudanças climáticas”. A administração Trump reduziu o financiamento para pesquisas que estudam a desinformação e encerrou iniciativas de DEI, bem como demitiu pesquisadores que trabalhavam no relatório de Avaliação Climática Nacional dos EUA e cortou gastos com energia limpa em um projeto de lei apoiado pelo Congresso dominado pelos republicanos.

“Os sistemas de IA não podem ser considerados ‘livres de preconceitos de cima para baixo’ se o governo impõe a sua visão do mundo aos criadores e utilizadores destes sistemas”, disse Branum. “Esses padrões pouco claros estão sujeitos a abusos.”

Agora, os criadores de IA que detêm ou procuram contratos federais enfrentam a perspectiva de ter de cumprir o impulso da administração Trump para modelos de IA livres de “preconceitos ideológicos”. Amazon, Google e Microsoft firmaram contratos federais para fornecer serviços baseados em IA e computação em nuvem para várias agências governamentais, enquanto a Meta tomou suas próprias decisões. Llamai você tem um modelo disponível para uso por agências governamentais dos EUA que trabalham em aplicações de defesa e segurança nacional.

Em julho de 2025, Chefe do Escritório de Inteligência Digital e Artificial do Departamento de Defesa dos EUA anunciou que havia concedido um novo contrato no valor de até US$ 200 milhões cada para Anthropic, Google, OpenAI e xAI de Elon Musk. A inclusão do xAI é importante considerando o papel recente de Musk na liderança da força-tarefa DOGE do presidente Trump, que demitiu milhares de funcionários do governo – para não mencionar o chatbot do xAI, Grok, que recentemente ganhou as manchetes por expressar opiniões racistas e anti-semitas enquanto se descrevia como “MechaHitler”. Nenhuma das empresas respondeu quando contactada pela Novo Cientistamas alguns apontaram para as declarações públicas dos seus executivos elogiando o plano de acção de IA de Trump.

Em qualquer caso, será difícil para as empresas de tecnologia garantir que os seus modelos de IA estejam sempre alinhados com a visão de mundo preferida da administração Trump, afirmou. Paulo atirou na Universidade Bocconi, na Itália. Isso ocorre porque grandes modelos de linguagem – os modelos que alimentam chatbots de IA populares como o ChatGPT da OpenAI – têm certas tendências ou preconceitos incorporados com base nos dados da Internet nos quais foram treinados.

Alguns chatbots de IA populares de desenvolvedores dos EUA e da China mostram visões surpreendentemente semelhantes que estão mais alinhadas com as atitudes dos eleitores liberais dos EUA em muitas questões políticas – como a igualdade salarial entre homens e mulheres e a participação de mulheres trans nos esportes femininos – quando usados para escrever tarefas de ajuda, de acordo com pesquisa de Röttger e seus colegas. Não está claro por que essa tendência ocorreu, mas a equipe especula que pode ser uma consequência do treinamento de modelos de IA para seguir princípios mais gerais, como incentivar a honestidade, a justiça e a gentileza, em vez de os desenvolvedores alinharem especificamente os modelos com atitudes liberais.

Os desenvolvedores de IA ainda podem “direcionar o modelo para escrever coisas muito específicas sobre certos problemas”, ajustando a resposta da IA a solicitações específicas dos usuários, mas isso não mudará de forma abrangente a postura do modelo e seus preconceitos implícitos, disse Röttger. Esta abordagem também pode colidir com os objetivos gerais de treinamento de IA, como priorizar a correção, disse ele.

As empresas tecnológicas dos EUA também poderão potencialmente alienar muitos dos seus clientes em todo o mundo se tentarem alinhar os seus modelos comerciais de IA com a visão do mundo da administração Trump. “Estou interessado em ver como isto funcionaria se os EUA tentassem agora impor uma certa ideologia a um modelo com uma base de utilizadores global”, disse Röttger. “Acho que pode ficar muito confuso.”

Modelos de IA podem tentar fazer isso neutralidade política aproximada se seus desenvolvedores compartilhassem mais informações publicamente sobre os preconceitos de cada modelo ou construíssem um “conjunto intencionalmente diversificado de modelos com diferentes tendências ideológicas”, disse Jillian Fisher na Universidade de Washington. Mas “atualmente, a criação de modelos de IA verdadeiramente politicamente neutros pode ser impossível, dada a natureza subjetiva da neutralidade e o grande número de escolhas humanas necessárias para construir esses sistemas”, disse ele.

Tópico: